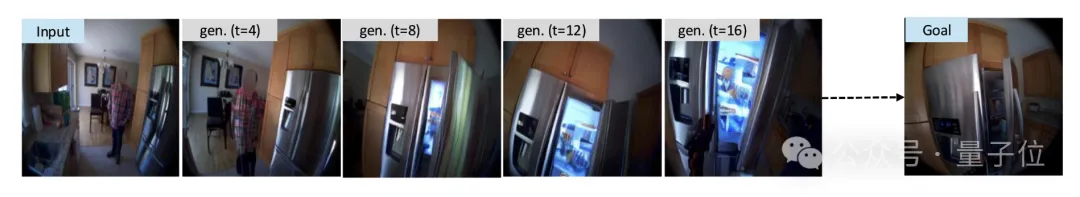

LeCun在干嘛呢? 就在扎克伯克亲自带队Meta的AI项目,千亿薪酬挖得硅谷人心浮动之际。Meta在AI领域最负盛名的大佬、图灵奖得主、深度学习三巨头之一的Yann LeCun,却几乎声量全无,他没有参与LLM基础模型的研发,也开始在社交网络上消停了。 LeCun是要离开Meta了吗? 不不不。他可能只是在憋自己想追逐的大招,比如——世界模型。而且就在最近,LeCun团队的世界模型新进展来了。 名叫PEVA模型,新突破是让具身智能体学会这人类一样的“预判能力”,首次实现16秒连贯场景预测。怎么说呢?就像人类伸手时会预判手臂进入视野的角度、走路时会提前观察脚下路径,LeCun团队的最新模型,可以让机器人实现这样的能力。 该模型通过结构化动作表示将人体48维关节运动学数据与条件扩散Transformer结合。 利用VAE编码视频帧、自适应层归一化嵌入动作条件及跨历史帧注意力机制等,实现了从全身动作预测第一视角视频的高精度生成与长期时序连贯。

PEVA模型让具身智能体不再依赖“上下左右”这种抽象信号进行训练,而是以第一人称视角的视频+全身姿态轨迹为输入,让它 “模仿” 人类第一视角下的动作与感知。

通过随机时间跳跃与跨历史帧注意力,解决了扩散模型在长时序动作预测中的计算效率与延迟效应问题。 |

| ||||||||||||||||||||||

点击朱笔,直抒胸臆